在大数据时代,处理和分析大规模数据集已成为一项日常任务,MapReduce,作为一种编程模型,广泛用于分布式系统中处理大规模数据,我们将深入探讨如何使用MapReduce框架来统计大文件中的行数。

MapReduce基础

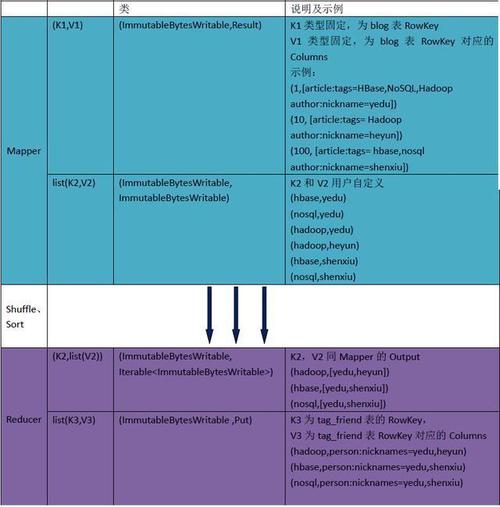

MapReduce的核心思想是将大规模数据分布至多个节点进行并行计算,其工作流主要分为两个阶段:Map阶段和Reduce阶段,Map阶段的任务是将输入数据分解成多个子任务,每个子任务会生成一组中间键值对,Reduce阶段则负责汇总这些中间数据,产生最终结果。

代码实现

1. Mapper类的实现

Mapper类的任务是读取输入数据,并为每一行数据生成一个键值对,在这个案例中,键(key)可以是每一行数据的起始字符的索引,而值(value)则固定为1,表示此行数据的存在,这样做的目的是将统计行数的任务转化成了一个计数问题,即统计所有键值对中的值的总和。

在Hadoop框架下,Mapper类的实现需要继承自Mapper类,并重写map方法,该方法将会对每一行输入数据调用一次,生成相应的键值对。

代码示例:

“`java

import org.apache.hadoop.io.*;

import org.apache.hadoop.mapreduce.*;

public class LineCountMapper extends Mapper<LongWritable, Text, IntWritable, IntWritable> {

public void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

// 每一行生成一个键值对,键为行号(可以简化为1),值为1

context.write(new IntWritable(1), new IntWritable(1));

}

}

“`

2. Reducer类的实现

Reducer类的职责是接收来自Mapper的所有键值对,并根据键(key)将所有的值(value)进行累加,从而得到总的行数。

同样地,在Hadoop框架下,Reducer类需要继承自Reducer类,并重写reduce方法,此方法将对每一个唯一的键调用一次,将其对应的所有值进行汇总。

代码示例:

“`java

import org.apache.hadoop.io.*;

import org.apache.hadoop.mapreduce.*;

public class LineCountReducer extends Reducer<IntWritable, IntWritable, IntWritable, IntWritable> {

public void reduce(IntWritable key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

context.write(key, new IntWritable(sum));

}

}

“`

3. Driver类的实现

Driver类是MapReduce作业的入口,负责配置和提交MapReduce作业,它需要指定Mapper、Reducer、输入输出格式以及输出路径等参数。

代码示例:

“`java

import org.apache.hadoop.conf.*;

import org.apache.hadoop.util.*;

public class LineCountDriver {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "line count");

job.setJarByClass(LineCountDriver.class);

job.setMapperClass(LineCountMapper.class);

job.setCombinerClass(LineCountReducer.class);

job.setReducerClass(LineCountReducer.class);

job.setOutputKeyClass(IntWritable.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

“`

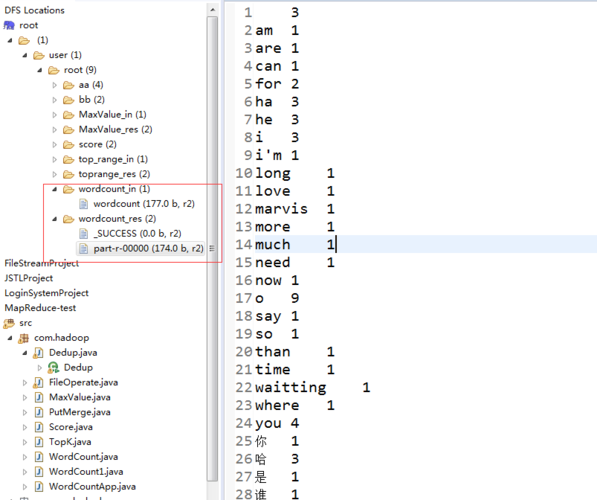

通过上述代码,我们成功实现了使用MapReduce框架统计大文件中行数的功能,在这个过程中,我们定义了三个核心组件:LineCountMapper、LineCountReducer和LineCountDriver,它们分别负责处理输入数据、汇总中间数据及配置作业参数。

FAQs

Q1: MapReduce程序如何实现跨多个节点的数据并行处理?

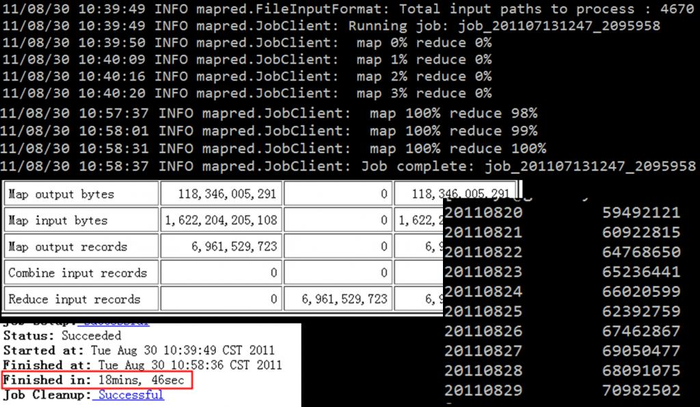

A1: MapReduce框架通过分布式存储和并行计算来实现数据处理,输入数据被分割成多个块,每个块由不同的Map任务处理,这些Map任务可以在集群的不同节点上并行执行,之后,Reduce任务会汇总Map任务的输出结果,这种模型利用了集群的并行处理能力,有效提高了数据处理的效率。

Q2: 如何在已实现的MapReduce程序中加入错误处理机制?

A2: 在MapReduce程序中加入错误处理机制通常涉及两个方面:输入数据验证和运行时异常捕获,可以在Mapper和Reducer的代码中添加输入数据的验证逻辑,确保数据的完整性和准确性,可以使用trycatch语句捕获和处理可能出现的运行时异常,如IOException和InterruptedException,在错误发生时,程序可以记录错误信息并决定是否继续执行或退出。

通过上述讨论,我们不仅掌握了使用MapReduce框架统计文件行数的方法,还了解了如何优化这一过程并处理潜在的错误,这为我们提供了一种强大的工具,以支持在大规模数据集上的复杂分析任务。

原创文章,作者:未希,如若转载,请注明出处:https://www.kdun.com/ask/867754.html

本网站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本网站。如有问题,请联系客服处理。

发表回复