MapReduce并行计算简介

MapReduce应用开发

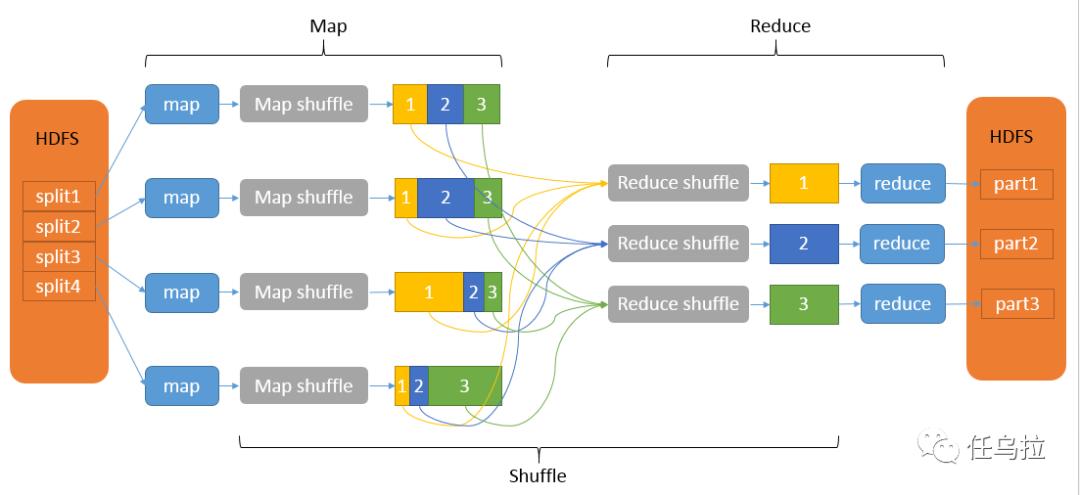

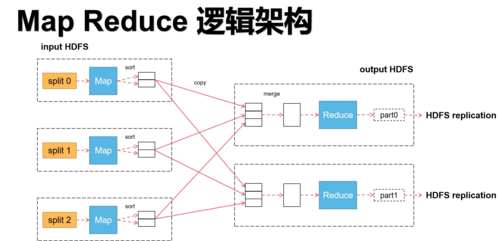

MapReduce框架作为大数据处理的基石,提供了大规模数据集的并行处理能力,MapReduce模型将复杂的数据处理任务分为两个核心阶段:Map和Reduce,Map阶段负责数据的初步处理,将输入数据转化为键值对;而Reduce阶段则对这些键值对进行进一步的聚合处理,以生成最终的结果,这种模型不仅简化了编程复杂度,还通过其分布式特性,实现了高效的数据处理。

MapReduce的核心概念和工作机制

MapReduce的核心在于其分布式和并行处理能力,在Map阶段,程序将处理输入的数据,并产生一系列的中间键值对,这些键值对将被传递给Reduce阶段,该阶段会对这些数据执行聚合操作,如统计、求和等,最终产生结果数据,这一过程利用了集群的计算资源,显著提高了处理速度和效率。

MapReduce的关键优势与挑战

MapReduce的设计允许系统自动进行数据分发和错误恢复,极大减轻了程序员的负担,随着数据量的急剧增加和任务类型的多样化,MapReduce在处理某些实时性较高或迭代计算较多的任务时,可能会表现出性能瓶颈,理解其适用场景与限制是开发高效MR应用的关键。

MapReduce的开发流程和工具支持

开发一个MapReduce应用通常包括定义Mapper和Reducer函数,配置运行环境,以及调试和优化任务,Hadoop平台提供了丰富的工具和API支持,使开发者能够方便地编写、测试和部署MR任务,各种监控和分析工具也帮助开发者有效地管理和优化其MR应用的性能。

相关FAQs

Q1: MapReduce框架适合处理什么样的数据任务?

A1: MapReduce框架特别适合于处理大规模非结构化或半结构化数据,如文本、日志文件等,它能够有效处理的任务类型包括数据清洗、转换,以及大规模的数据聚合和统计。

Q2: 如何优化MapReduce任务的执行效率?

A2: 优化MapReduce任务的效率可以从以下几个方面入手:合理设置数据分片以平衡Map任务的负载、优化数据序列化和传输格式减少I/O开销、选择合适的数据压缩方法减少网络传输量,以及使用Combiner减少数据在Map和Reduce之间的传输,代码级别的优化,如改进算法逻辑和合理使用缓存,也可以显著提高任务的执行效率。

原创文章,作者:未希,如若转载,请注明出处:https://www.kdun.com/ask/852854.html

本网站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本网站。如有问题,请联系客服处理。

发表回复