MapReduce是一个分布式计算框架,用于处理和生成大规模数据集,具体如下:

1、介绍与概念

定义:MapReduce是一个编程模型和一个处理框架,用于在大规模数据集上并行运行计算任务,它适用于大于1TB的数据集处理,并支持分布式并行处理。

核心思想:MapReduce借鉴了函数式编程中的“Map(映射)”和“Reduce(归约)”概念,以及矢量编程语言的特性,简化了大规模数据操作的复杂性。

历史背景:MapReduce最初由谷歌提出,用来支撑其搜索引擎的数据处理方法,后来这一计算模型被广泛应用于其他大数据处理场景。

2、主要功能与组件

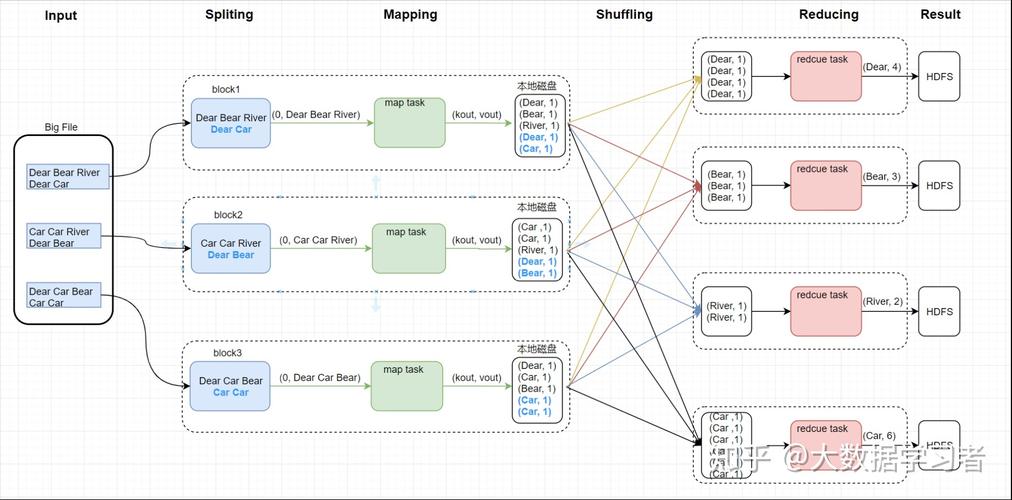

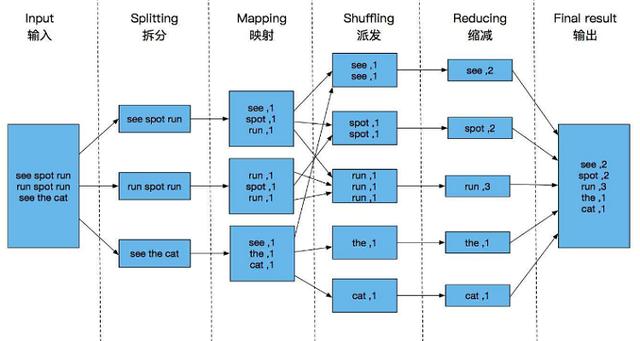

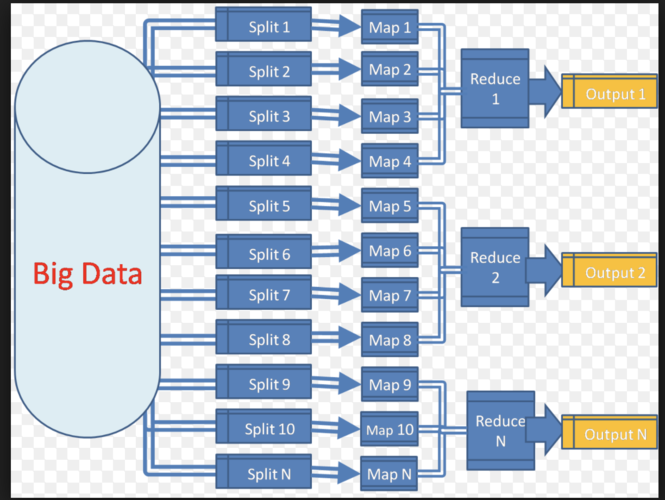

数据划分:系统自动将待处理的大数据划分为多个数据块,每个数据块对应一个计算任务,这有助于并行处理并提高计算效率。

任务调度:MapReduce框架负责分配和调度计算节点,包括Map节点和Reduce节点,同时监控这些节点的执行状态,确保计算任务的有效进行。

数据和代码互定位:框架设计使得数据和代码能够在同一位置处理,减少数据传输,优化处理速度和资源使用率。

3、处理阶段

Map阶段:在这一阶段,框架读取存储在HDFS(Hadoop Distributed File System)中的数据,通过Map函数处理这些数据,生成中间键值对。

Shuffle阶段:Shuffle阶段是连接Map和Reduce阶段的桥梁,它负责对Map阶段的输出进行排序和传输,为Reduce阶段准备好数据。

Reduce阶段:在Reduce阶段,框架使用用户定义的Reduce函数处理来自Map阶段的数据,整合并输出最终结果。

4、技术实现与应用

Hadoop MapReduce:在Apache Hadoop生态系统中,MapReduce是核心框架之一,用于开发基于Hadoop的数据分析应用。

与其他技术融合:MapReduce通常与HDFS等存储技术结合使用,以支持数据的高效读写和快速访问。

5、优势与挑战

优势:MapReduce简化了并行程序的开发,使其能够轻松处理和分析大规模数据集,尤其适合那些需要高计算量的任务。

挑战:虽然MapReduce在数据处理方面非常强大,但它在处理具有高实时性要求的任务时可能不是最佳选择,因为其设计主要是为了处理静态数据。

随着技术的发展,MapReduce已经成为大数据分析不可或缺的一部分,对于企业和研究机构而言,了解和掌握MapReduce的原理和应用是释放数据价值的关键步骤。

可以看出MapReduce不仅是大数据处理的强大工具,它的设计理念和技术实现也极大地推动了数据处理技术的发展。

原创文章,作者:未希,如若转载,请注明出处:https://www.kdun.com/ask/830593.html

本网站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本网站。如有问题,请联系客服处理。

发表回复