分布式爬虫框架是一类用于实现大规模数据抓取的工具,它们通过在多台机器上并行处理任务来提高爬取效率和速度,以下是具体介绍:

1、Celery:Celery 是一个强大的异步任务队列/作业队列,专注于实时处理的任务队列,支持任务调度,它适用于执行长时间运行或资源密集型任务,可以有效地用于分布式爬虫中的任务分配和资源调度,Celery 使用消息传输机制,通常结合中间人(Broker)和后端(Backend)进行任务的发送和状态存储,常用的Broker 有 RabbitMQ 和 Redis 等。

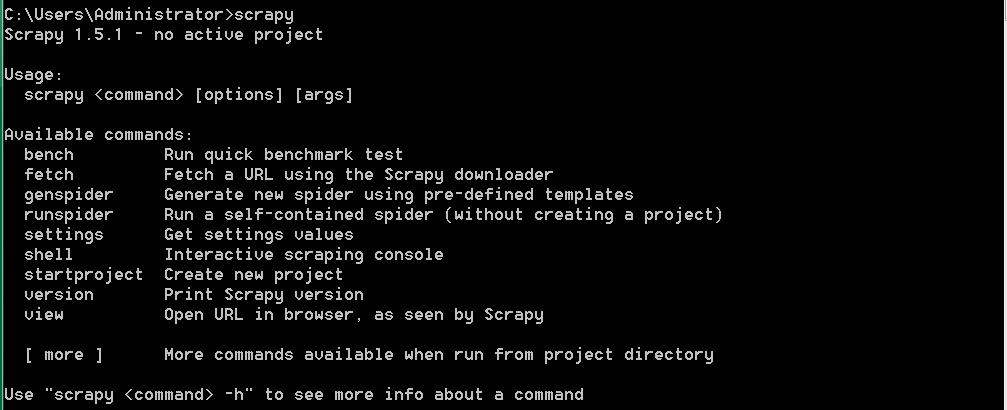

2、ScrapyRedis:ScrapyRedis 是为了支持 Scrapy 实现分布式爬取的组件,Scrapy 本身是一个流行的 Python 爬虫框架,但它并不原生支持分布式,通过使用 ScrapyRedis,可以使多个 Scrapy 爬虫共享爬取队列,从而实现分布式抓取,ScrapyRedis 依赖于 Redis 数据库进行任务的调度和结果的存储。

3、Cola:Cola 是一个相对轻量级的分布式爬虫框架,它允许用户编写几个特定函数来完成任务的分布式处理,而无需关注分布式运行的细节,该框架自动将任务分发到多台机器上,并对外提供简洁的使用接口,Cola 的安装和配置过程简单,适合中小型分布式爬虫项目。

4、PySpider:PySpider 是一个强大的网页抓取系统,它具有强大的WebUI,让用户可以很方便地监控和管理爬取任务,PySpider 不仅支持分布式爬取,还具有强大的JS渲染能力,可以应对许多动态网页的爬取需求。

在选择和搭建分布式爬虫框架时,需要考虑多个因素以确保系统的高效运行:

1、任务调度与负载均衡:确保任务能够均匀地分配到各个爬取节点,避免单个节点过载。

2、数据一致性与去重:在多节点同时工作时,需要保证同一资源不被重复抓取,并且数据不冲突。

3、异常处理与监控:分布式爬虫需要具备完善的异常处理机制,以及实时监控系统运行状态的能力。

4、反爬机制应对:合理设置请求频率、使用代理IP等方式,以避免被目标网站封锁。

选择合适的分布式爬虫框架取决于具体的项目需求、团队的技术栈以及预期的扩展性,高效的分布式爬虫系统需要在保证数据质量和遵守目标网站规则的基础上,提升爬取速度和数据处理能力。

原创文章,作者:未希,如若转载,请注明出处:https://www.kdun.com/ask/768977.html

本网站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本网站。如有问题,请联系客服处理。

发表回复