FlinkCDC源表为Oracle表时,使用initial方式全量同步时,只同步过来一条数据

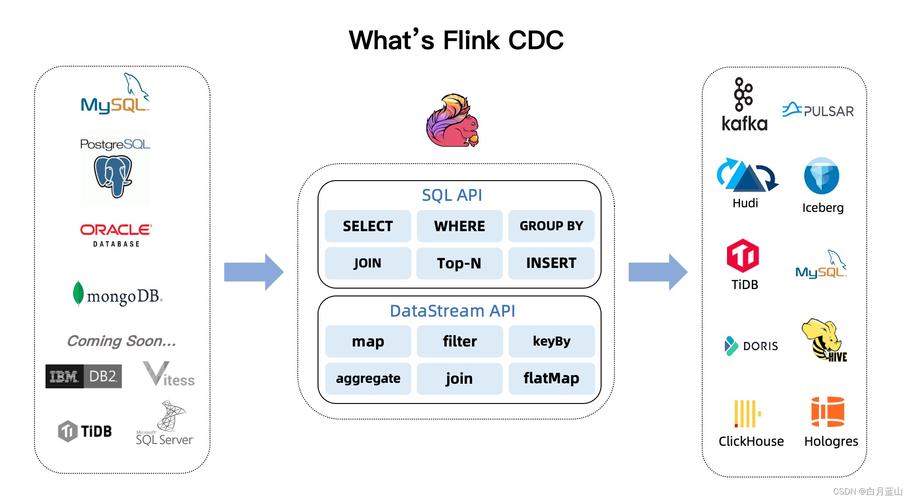

在Apache Flink中,Change Data Capture (CDC) 是一种用于捕获和同步数据库变更的技术,当Flink CDC源表为Oracle表时,用户可以选择使用initial方式进行全量同步,即在首次同步时获取表中的所有数据,在某些情况下,用户可能会遇到一个问题:尽管表中有大量数据,但使用initial方式全量同步时,只同步过来一条数据,本文将详细探讨这个问题的原因以及解决方案。

原因分析

1、Oracle Redo Log配置问题:Oracle的Redo Log是记录数据库变更的重要机制,如果Redo Log配置不当或者未启用,可能会导致Flink CDC无法正确捕获所有变更。

2、Flink CDC配置问题:Flink CDC的配置参数可能没有正确设置,导致无法捕获所有数据。

3、Oracle表结构问题:某些特殊的表结构可能导致Flink CDC无法正确解析所有数据。

4、网络或资源限制:网络延迟或资源限制可能导致Flink CDC在处理大量数据时出现问题。

解决方案

1、检查Oracle Redo Log配置:确保Oracle的Redo Log已经启用并且配置正确,可以咨询Oracle管理员获取更多信息。

2、调整Flink CDC配置:根据具体情况调整Flink CDC的配置参数,例如调整并行度、缓冲区大小等。

3、优化Oracle表结构:如果可能,优化Oracle表的结构,使其更适合Flink CDC的处理。

4、增加资源:增加Flink任务的资源,例如增加CPU、内存等,以提高处理能力。

示例代码

以下是一个简单的Flink CDC配置示例:

val sourceTable = new OracleSourceTable(

"source_table", // 表名

"jdbc:oracle:thin:@localhost:1521:xe", // JDBC连接字符串

"username", // 用户名

"password" // 密码

)

val initialOffset = InitialOffset.latest() // 使用最新的初始偏移量

val sourceFunction = new OracleSourceFunction(sourceTable, initialOffset)

val streamEnv = StreamExecutionEnvironment.getExecutionEnvironment

streamEnv.addSource(sourceFunction).print()

streamEnv.execute("Oracle CDC Job")

相关问答FAQs

Q1: 如果我已经启用了Oracle的Redo Log,为什么还是只能同步一条数据?

A1: 即使启用了Redo Log,也可能存在其他问题,请检查Flink CDC的配置是否正确,特别是初始偏移量的设置,确保Oracle表的结构适合Flink CDC的处理。

Q2: 我是否可以在不修改Oracle表结构的情况下解决这个问题?

A2: 是的,通常你不需要修改Oracle表的结构,你可以调整Flink CDC的配置,例如增加并行度或缓冲区大小,以提高处理能力,如果问题仍然存在,建议咨询Oracle管理员或查阅相关文档以获取更多信息。

原创文章,作者:未希,如若转载,请注明出处:https://www.kdun.com/ask/667905.html

本网站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本网站。如有问题,请联系客服处理。

发表回复